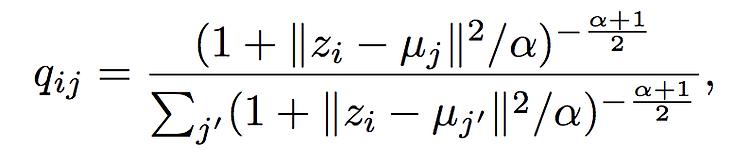

Generative Adversarial Nets 논문 링크 : https://papers.nips.cc/paper/5423-generative-adversarial-nets.pdf Abstract 우리는 적대적인(adversarial) 과정을 통해 생성모델을 평가하는 새 프레임워크를 제안한다. 생성 모델 G : 데이터의 분포를 학습하는 모델감별 모델 D : 생성모델 G로부터가 아닌, 훈련 데이터로 부터 나왔을 확률을 추정하는 감별 모델G 모델 훈련 과정은 D가 실수할 확률을 최대화 하는 것이다.이 프레임워크는 minimax 2인 게임이다.임의의 함수 G와 D의 공간에서, G는 훈련 데이터의 분포를 복구하고, D는 항상 1/2이 되는 고유한 솔루션이 존재한다.즉, G는 훈련 데이터의 분포를 학습하여, 임..